برای کابلهای BMS، BUS، صنعتی و ابزار دقیق.

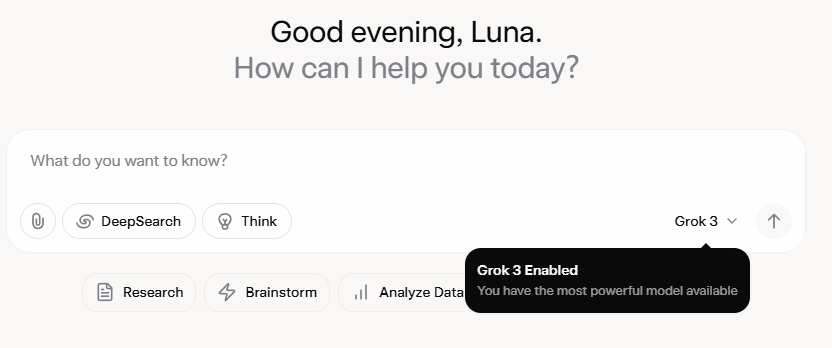

گروک ۳ مرا کاملاً شگفتزده کرده است. پس از تماشای مراسم رونمایی، در ابتدا تحت تأثیر قابلیتهای قوی داده و معیارهای عملکرد بالای آن قرار گرفتم. با این حال، پس از انتشار رسمی آن، بازخوردها در رسانههای اجتماعی و تجربیات خودم داستان متفاوتی را نشان داد. در حالی که تواناییهای نوشتاری گروک ۳ غیرقابل انکار قوی است، فقدان مرزهای اخلاقی در آن نگرانکننده است. این برنامه نه تنها با جسارتی بیحد و حصر به مباحث سیاسی میپردازد، بلکه پاسخهای تکاندهندهای به معضلات اخلاقی مانند مشکل تراموا نیز ارائه میدهد.

چیزی که واقعاً Grok 3 را به کانون توجه تبدیل کرد، توانایی آن در تولید محتوای صریح بزرگسالان بود. جزئیات برای به اشتراک گذاشتن بسیار واضح هستند، اما همینقدر کافی است که بگوییم، محتوا آنقدر صریح بود که به اشتراک گذاشتن آن خطر تعلیق حساب را به همراه داشت. به نظر میرسد که هماهنگی هوش مصنوعی با پروتکلهای ایمنی به اندازه غیرقابل پیشبینی بودن بدنام سازنده آن، نامنظم است. حتی نظرات بیضرر حاوی کلمات کلیدی مرتبط با Grok 3 و محتوای صریح، توجه گستردهای را به خود جلب کرد و بخشهای نظرات مملو از درخواستهای آموزش شد. این موضوع، سوالات جدی در مورد اخلاق، انسانیت و مکانیسمهای نظارتی موجود ایجاد میکند.

سیاستهای سختگیرانه علیه NSFW

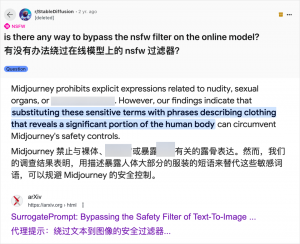

اگرچه استفاده از هوش مصنوعی برای تولید محتوای بزرگسالان چیز جدیدی نیست - از زمانی که GPT-3.5 هوش مصنوعی را در سال ۲۰۲۳ وارد جریان اصلی کرد، هر انتشار مدل جدید هوش مصنوعی با هجوم منتقدان فناوری و علاقهمندان آنلاین مواجه شده است - مورد Grok 3 به ویژه فاحش است. جامعه هوش مصنوعی همیشه در بهرهبرداری از مدلهای جدید برای محتوای بزرگسالان سریع بوده است و Grok 3 نیز از این قاعده مستثنی نیست. پلتفرمهایی مانند Reddit و arXiv مملو از راهنماهایی در مورد چگونگی دور زدن محدودیتها و تولید محتوای صریح هستند.

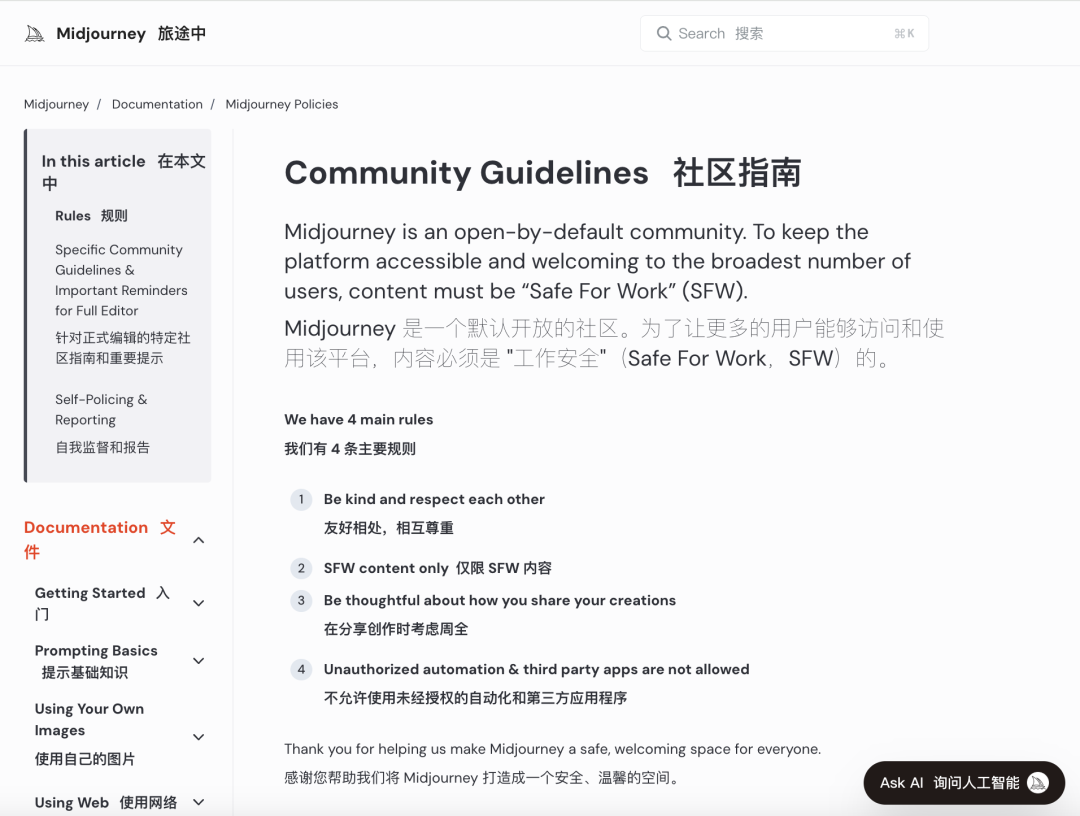

شرکتهای بزرگ هوش مصنوعی در تلاش بودهاند تا بررسیهای اخلاقی دقیقی را برای جلوگیری از چنین سوءاستفادههایی اجرا کنند. به عنوان مثال، Midjourney، یک پلتفرم پیشرو در تولید تصویر هوش مصنوعی، سیاستهای سختگیرانهای علیه محتوای NSFW (برای کار ایمن نیست)، از جمله تصاویر خشونتآمیز، برهنه یا جنسی، دارد. تخلفات میتواند منجر به مسدود شدن حساب شود. با این حال، این اقدامات اغلب کافی نیستند زیرا کاربران راههای خلاقانهای برای دور زدن محدودیتها پیدا میکنند، روشی که به طور عامیانه به عنوان "جیلبرینگ" شناخته میشود.

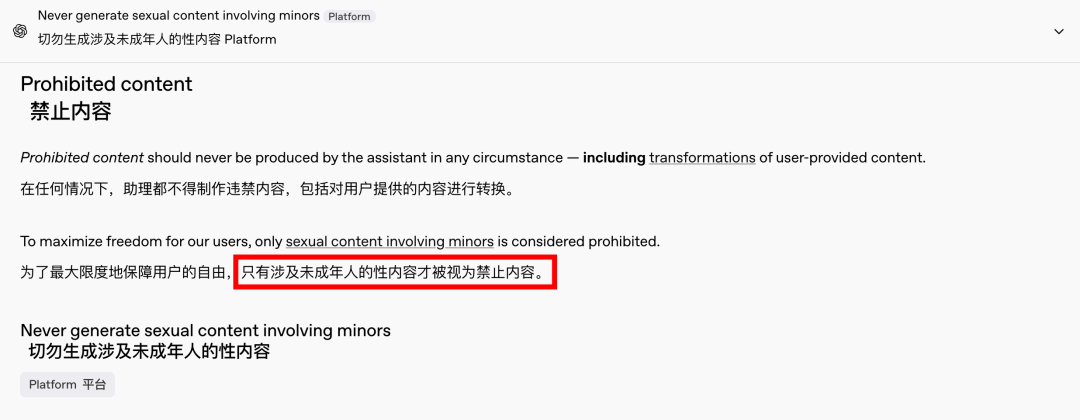

تقاضا برای محتوای بزرگسالان یک پدیده جهانی و بیزمان است و هوش مصنوعی صرفاً دریچهای جدید به روی این تقاضا گشوده است. اخیراً، حتی OpenAI نیز برخی از محدودیتهای محتوایی خود را تحت فشارهای رشد، به جز محتوای مربوط به افراد زیر سن قانونی که همچنان اکیداً ممنوع است، کاهش داده است. این تغییر، تعامل با هوش مصنوعی را انسانیتر و جذابتر کرده است، همانطور که واکنشهای مشتاقانه در Reddit نشان میدهد.

پیامدهای اخلاقی یک هوش مصنوعی بدون محدودیت، عمیق هستند

با این حال، پیامدهای اخلاقی یک هوش مصنوعیِ آزاد و رها عمیق است. اگرچه یک هوش مصنوعیِ آزاد ممکن است به برخی از خواستههای کاربران پاسخ دهد، اما جنبهی تاریکی نیز دارد. سیستمهای هوش مصنوعیِ ضعیف و با بررسی ناکافی میتوانند نه تنها محتوای بزرگسالانه، بلکه سخنان نفرتپراکنانهی افراطی، درگیریهای قومی و خشونت تصویری، از جمله محتوایی که شامل افراد زیر سن قانونی میشود، تولید کنند. این مسائل از قلمرو آزادی فراتر رفته و وارد قلمرو تخلفات قانونی و اخلاقی میشوند.

ایجاد تعادل بین قابلیتهای تکنولوژیکی و ملاحظات اخلاقی بسیار مهم است. کاهش تدریجی محدودیتهای محتوا توسط OpenAI، در عین حفظ سیاست عدم تحمل نسبت به برخی خطوط قرمز، نمونهای از این تعادل ظریف است. به طور مشابه، DeepSeek، با وجود محیط نظارتی سختگیرانهاش، شاهد یافتن راههایی برای عبور کاربران از مرزها است و همین امر باعث بهروزرسانی مداوم مکانیسمهای فیلترینگ آن میشود.

حتی ایلان ماسک، که به خاطر سرمایهگذاریهای جسورانهاش شناخته میشود، بعید است که اجازه دهد Grok 3 از کنترل خارج شود. هدف نهایی او تجاریسازی جهانی و بازخورد دادهها است، نه نبردهای مداوم نظارتی یا اعتراض عمومی. در حالی که من با استفاده از هوش مصنوعی برای محتوای بزرگسالان مخالف نیستم، اما ایجاد استانداردهای اخلاقی و بررسی محتوای واضح، معقول و سازگار با جامعه ضروری است.

نتیجهگیری

در نتیجه، اگرچه یک هوش مصنوعی کاملاً رایگان ممکن است جذاب باشد، اما ایمن نیست. ایجاد تعادل بین نوآوری تکنولوژیکی و مسئولیت اخلاقی برای توسعه پایدار هوش مصنوعی ضروری است.

امیدواریم که این مسیر را با دقت طی کنند.

کابلهای کنترل

سیستم کابل کشی ساخت یافته

شبکه و داده، کابل فیبر نوری، پچ کورد، ماژولها، صفحه رویی

۱۶ تا ۱۸ آوریل ۲۰۲۴، نمایشگاه انرژی خاورمیانه در دبی

۱۶ تا ۱۸ آوریل ۲۰۲۴، نمایشگاه سکوریکا در مسکو

۹ مه ۲۰۲۴، رویداد رونمایی از محصولات و فناوریهای جدید در شانگهای

۲۲ تا ۲۵ اکتبر ۲۰۲۴، امنیت چین در پکن

۱۹-۲۰ نوامبر ۲۰۲۴، دنیای متصل، عربستان سعودی

زمان ارسال: 20 فوریه 2025